如何自动化 URL 检查 API

了解如何批量收集 URL 检查 API 数据,处理或规避 2k 限制的选项,以及如何自动化 URL 检查数据报告以监控索引。

如何自动化 URL 检查 API

Google URL 检查 API 允许用户请求 Search Console 拥有的关于 URL 索引版本的数据,包括索引状态、覆盖率、富媒体搜索结果、移动设备易用性等等。

这意味着您可以批量检查 URL 是否已在 Google 上建立索引,以及是否存在警告或问题。

URL 检查 API 已集成到 Screaming Frog SEO Spider 中,因此用户每天可以从每个属性中提取最多 2k 个 URL 的数据,以及所有常用的抓取数据。

本教程向您展示如何使用 SEO Spider 收集 URL 检查数据,处理或规避 2k URL 限制的选项,以及如何自动化 URL 检查 API 数据和报告以监控索引。

如何连接到 URL 检查 API

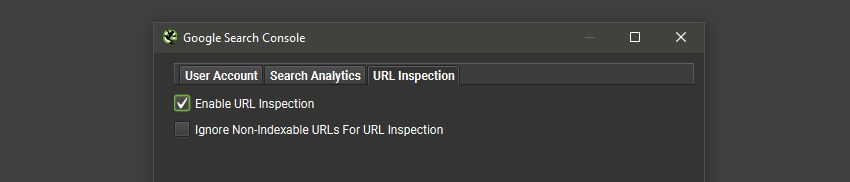

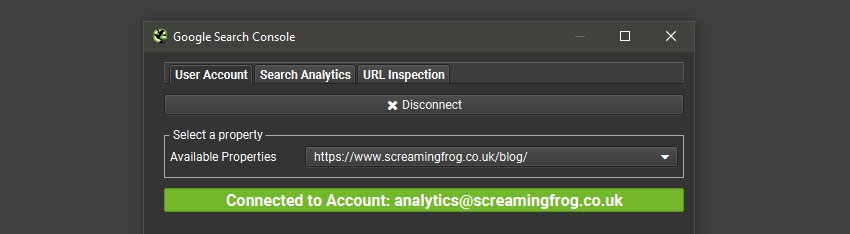

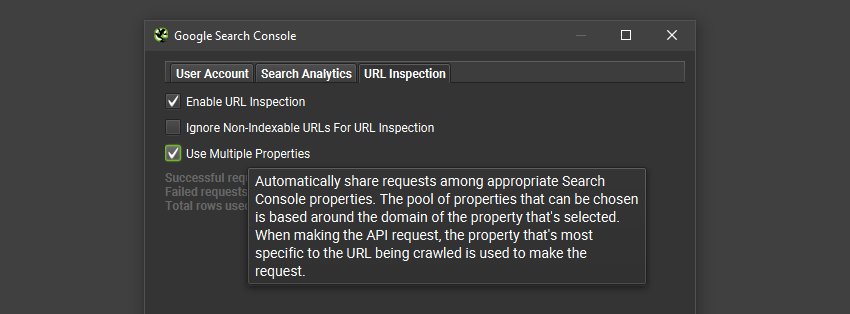

点击“Config > API Access > Google Search Console”,连接到 Search Console 帐户,选择属性,然后在“URL Inspection”选项卡下,选择“Enable URL Inspection”。

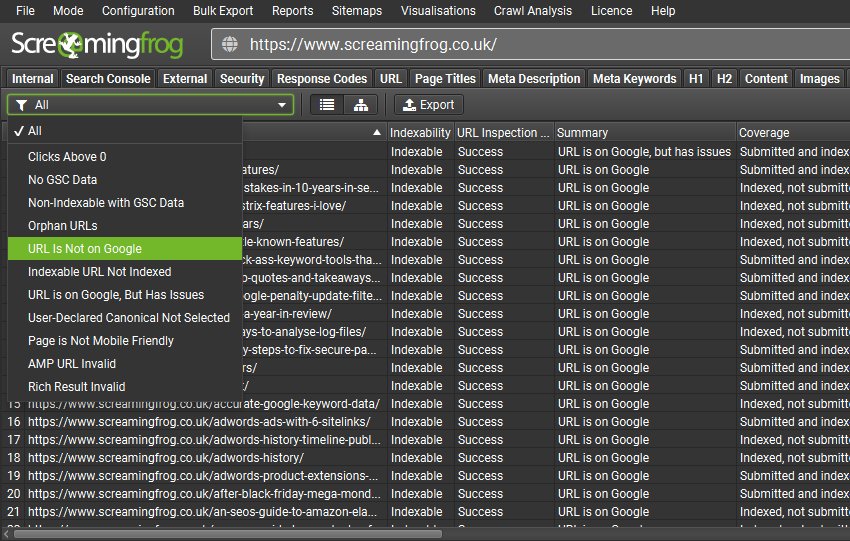

当您执行抓取时,URL 检查 API 数据将填充到“Search Console”选项卡中,与常用的 Search Analytics 数据(展示次数、点击次数等)一起显示。

Search Console 选项卡包括以下与 URL 检查 API 相关的过滤器 -

- URL Is Not on Google – 该 URL 未被 Google 索引,不会出现在搜索结果中。此过滤器可以包括不可索引的 URL(例如那些“noindex”的 URL)以及可以索引的 Indexable URL。根据 API,这是一个包含所有未在 Google 上的内容的过滤器。

- Indexable URL Not Indexed – 在抓取中找到的可以索引的 URL,但未被 Google 索引,也不会出现在搜索结果中。这可能包括 Google 未知的 URL,或者已被发现但未被索引的 URL 等等。

- URL is on Google, But Has Issues – 该 URL 已被索引,可以出现在 Google 搜索结果中,但在移动设备易用性、AMP 或富媒体搜索结果方面存在一些问题,这可能意味着它不会以最佳方式显示。

- User-Declared Canonical Not Selected – Google 已选择索引与用户在 HTML 中声明的 URL 不同的 URL。规范 URL 只是提示,有时 Google 会做得很好,有时则不太理想。

- Page Is Not Mobile Friendly – 该页面在移动设备上存在问题。

- AMP URL Is Invalid – AMP 存在错误,将阻止其被索引。

- Rich Result Invalid – 该 URL 在一个或多个富媒体搜索结果增强功能方面存在错误,这将阻止富媒体搜索结果在 Google 搜索结果中显示。

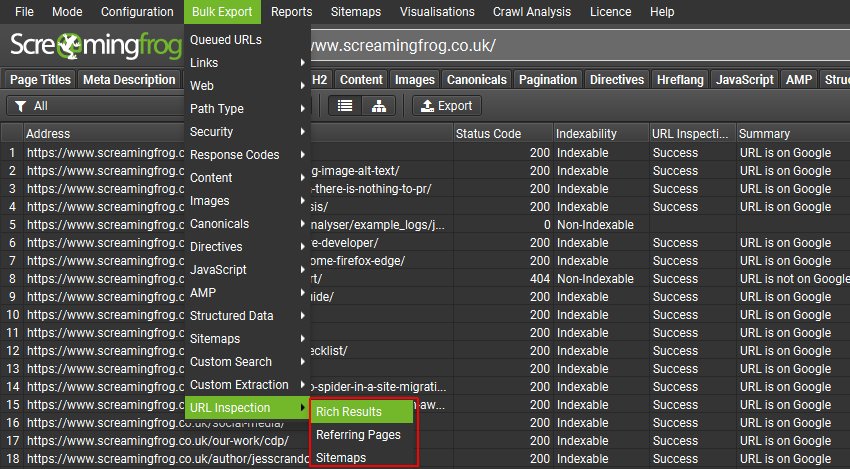

您可以通过“Bulk Export > URL Inspection”菜单导出 Google 富媒体搜索结果类型、错误和警告,以及有关引用页面和站点地图的详细信息。

如何专注于关键部分或页面

URL 检查数据将针对在抓取中找到的前 2k 个 URL 进行填充,这是从抓取的起始页面开始的广度优先(按抓取深度排序)。

使用 SEO Spider 配置将抓取重点放在关键部分、页面或各种模板类型上。

一些主要选项包括 -

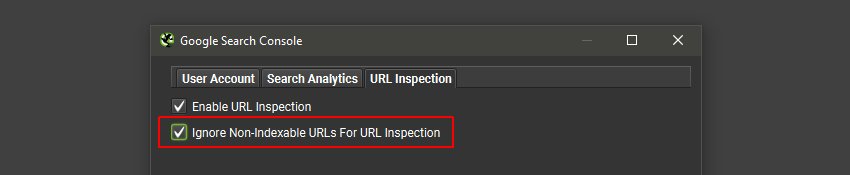

在“Config > API Access > Google Search Console”和“URL Inspection”选项卡下,您可以“Ignore Non-Indexable URLs for URL Inspection”,如果您只对抓取中可索引的 URL 的数据感兴趣。

这可以节省在您不关心的 URL 上浪费 2k 查询预算。

如何处理每天 2k 的限制

Google 对 URL 检查 API 具有每天每个属性 2k 个查询的限制。

Google 构建 API 并不是为了让网站管理员检查他们网站上的每个 URL 是否都已建立索引。他们认为某些 URL 未被索引是很正常的。API 的目的是允许用户一次检查多个 URL,并在 GSC 之外获得更好的模板样本。

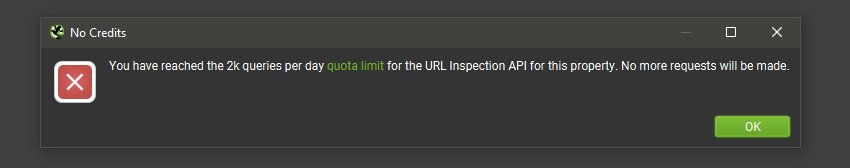

如果您已达到 URL 检查 API 每天每个属性 2k 个 URL 的限制,您将收到此消息。

抓取本身显然会继续并完成,只是 URL 将不再继续填充 URL 检查数据。如果您想要更多 URL 的数据,那么您有两个选择。

1) 耐心(等待一天!)

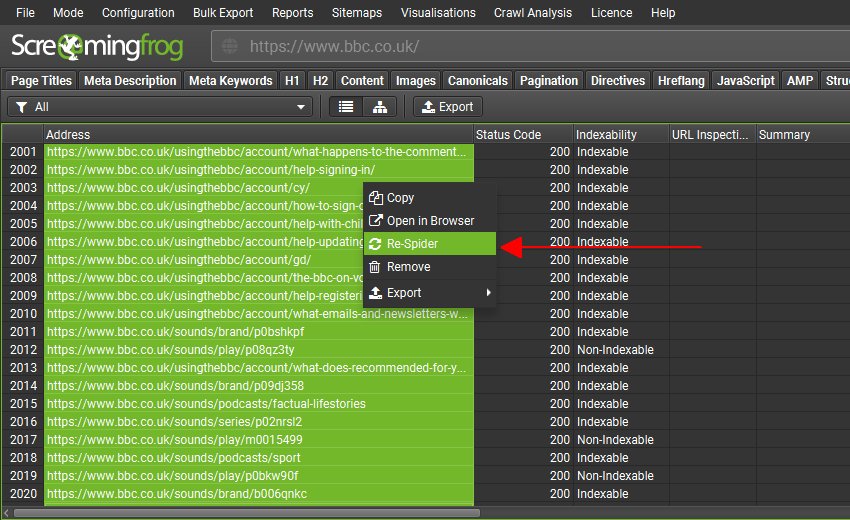

让抓取完成,等待 24 小时,重新打开抓取,再次连接到 API,然后批量突出显示并“重新抓取”接下来的 2k 个 URL 以获取 URL 检查 API 数据。

或者导出之前的抓取,复制您想要从中获取 URL 检查数据的 URL,并在列表模式中上传。

在导出并与前几天的抓取数据合并之前。

2) 验证多个属性并启用“使用多个属性”

您可以将多个子域名和子文件夹验证为站点中单独的 Search Console 属性。每个属性对于 URL 检查 API 都有 2k URL 的限制。

例如,如果 /blog/ 中的所有 URL 都被验证为一个属性,则它们可以拥有自己的 2k 查询限制。

如果您有多个子域名或子文件夹设置为单独的属性,则启用在“Config > API Access > GSC > URL Inspection”中找到的“Use Multiple Properties”配置。

SEO Spider 将自动检测帐户中的所有相关属性,并使用最具体的属性来请求 URL 的数据。

这意味着,如果设置了多个属性,现在可以在单个抓取中获得远远超过 2k 个带有 URL 检查 API 数据的 URL,而无需执行多次抓取。

如何自动化 URL 检查数据和索引监控

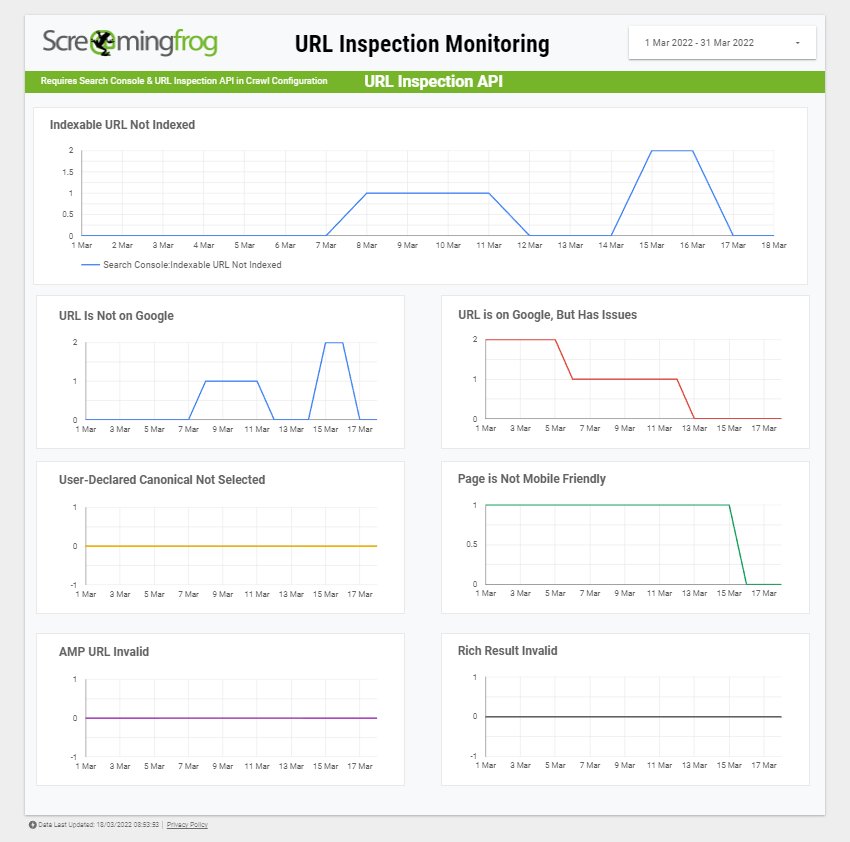

您可以通过多种方式自动化抓取并获取 URL 检查 API,以监控网站上最重要页面的索引。最简单的方法是使用计划、Google Data Studio 的导出功能以及我们新的 URL 检查 API Data Studio 模板。

如果您已经在 Data Studio 中自动化了抓取报告,那么您将熟悉此过程,并且此报告中有一个页面。让我们运行自动化索引监控的过程。

1) 计划列表模式抓取

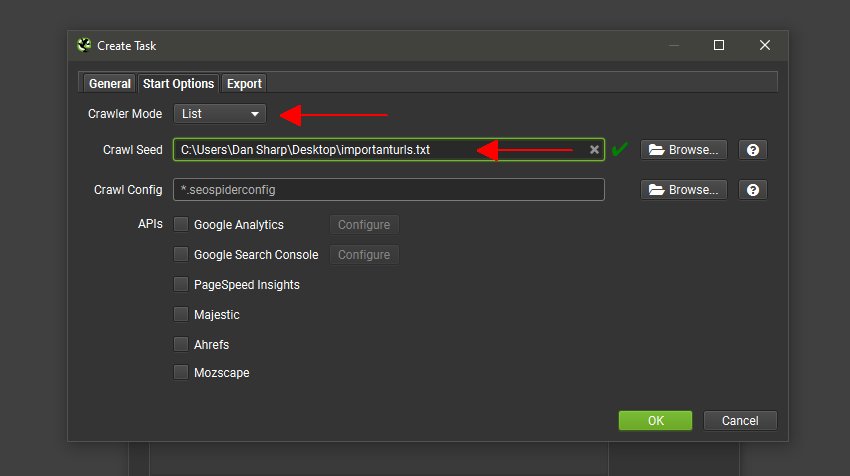

转到“File > Scheduling”,然后在“General”下选择一个任务和项目名称以及每日间隔。

接下来,单击“Start Options”并将“Crawler Mode”切换为“List”。对于“Crawl Seed”,单击“browse”并选择一个 .txt 文件,其中包含您想要每天检查 URL 检查数据的 URL。

如果网站上的 URL 少于 2k,您可以以常规的“Spider”模式抓取网站,并收集每个 URL 的索引数据。

但是,网站通常要大得多,并且可能有很多您不关心的 URL。因此,专注于网站上最重要的 URL 是有意义的。

这可能是前 10、20 或 100 个 URL,而不是 2k 个。因此,许多网站都有少量真正关键的着陆页来推动收入。

2) 使用启用了 URL 检查 API 的抓取配置

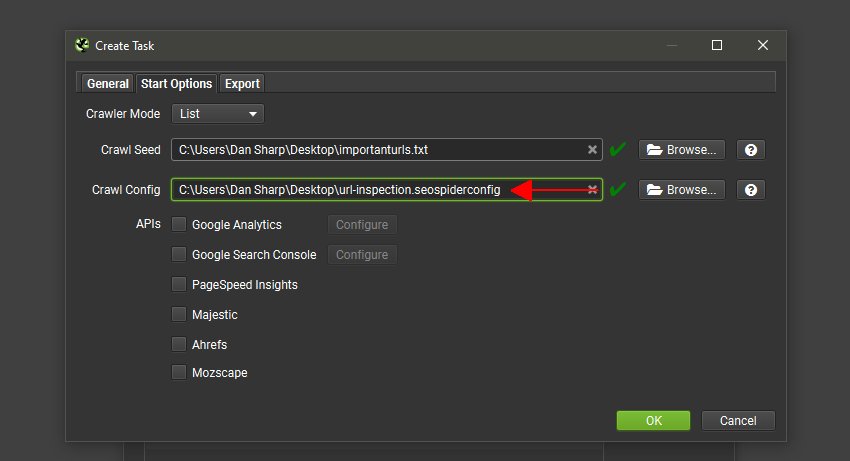

对于计划“Start Options”中的“Crawl Config”,请确保您提供了一个已保存的配置文件,该文件在“Config > API Access > Google Search Console > URL Inspection”中激活了“Enable URL Inspection”。

设置已保存的配置很简单。在 SEO Spider 界面中,只需选择您想要的配置,然后单击“File > Config > Save As”。这是需要在“Crawl Config”中提供的文件。

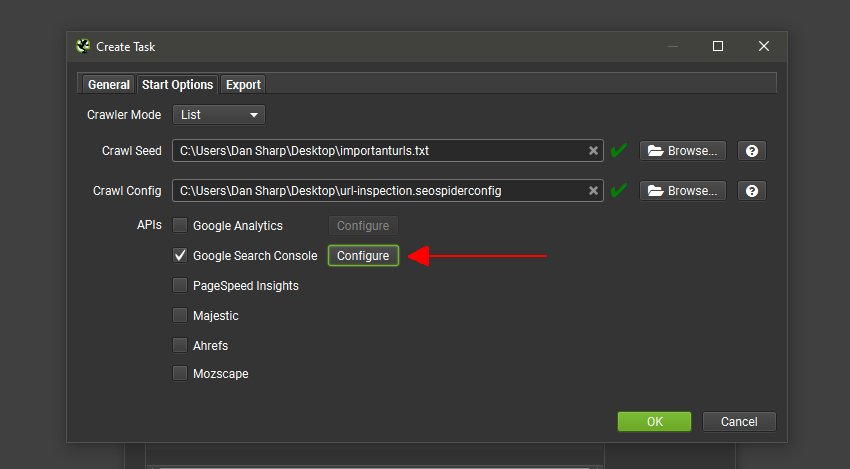

3) 选择 Google Search Console API

启用“Google Search Console”API,单击“Configure”并选择帐户和属性。

4) 导出到 Data Studio

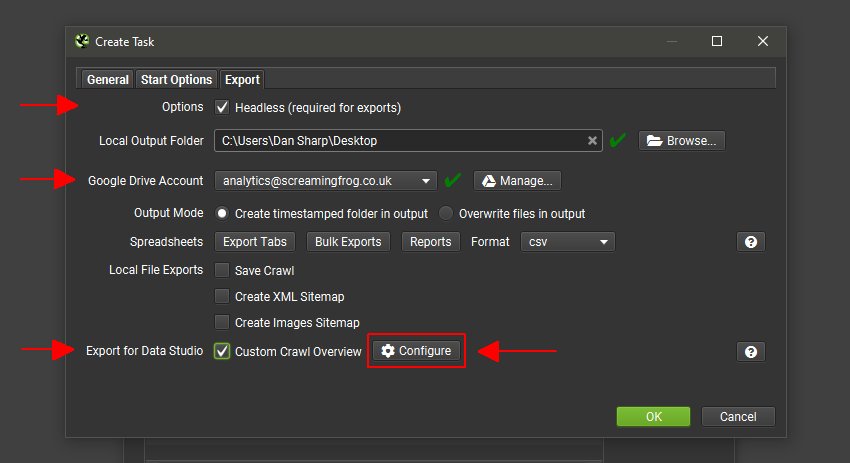

在“Export”选项卡上,启用“Headless”并选择“Google Drive Account”以将 URL 检查 API 数据导出到 Google Sheet 中。

接下来,单击“Export For Data Studio”,然后单击它旁边的“Configure”按钮。

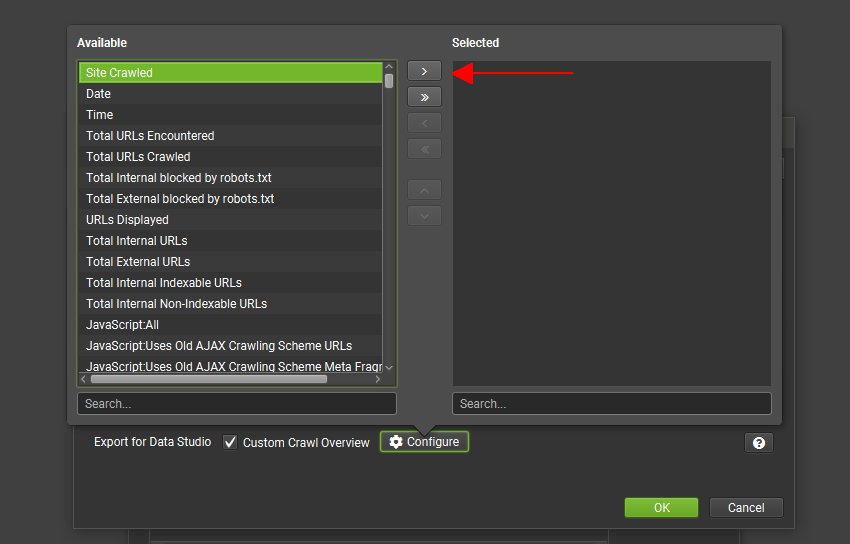

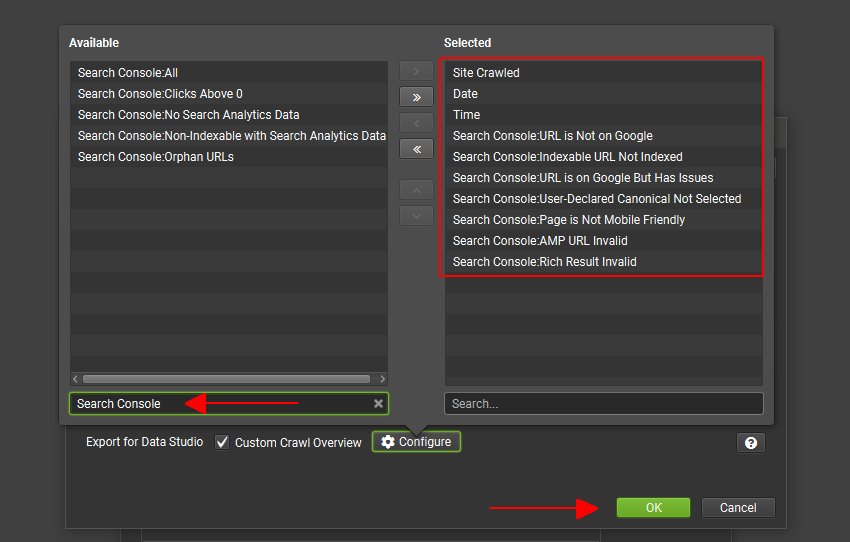

然后,配置按钮将向您显示左侧选项卡和过滤器中可用的指标列表,需要单击右箭头选择这些指标以进行导出。

选择“Site Crawled”、“Date”和“Time”指标,然后搜索“Search Console”以查看此选项卡可用的指标列表。选择底部的 7 个指标,这些指标与 URL 检查相关,然后单击右箭头。

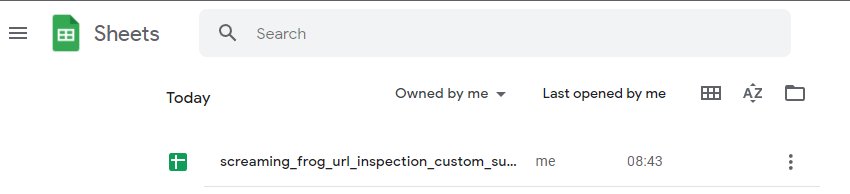

当计划的抓取运行后,“Export for Data Studio”Google Sheet 将导出到您选择的 Google Drive 帐户中。

默认情况下,“Export for Data Studio”的位置是“My Drive > Screaming Frog SEO Spider > Project Name > [task_name]_crawl_summary_report”。

5) 连接到 URL 检查 Google Data Studio 模板

现在复制我们的 URL 检查监控 Data Studio 模板,并连接到您自己的 Google Sheet,其中包含来自“Export for Data Studio”抓取摘要报告的数据。

您现在拥有了一个针对网站上最重要的 URL 的每日索引监控系统,该系统会提醒您任何未被索引或存在问题的 URL。

如果您不熟悉如何复制 Data Studio 仪表板并连接到不同的数据源,请阅读我们的“连接到 Data Studio‘ 指南,并按照相同的过程操作。

总结

本教程应有助于您利用 SEO Spider 获取您需要的 URL 检查 API 数据。

查看我们的 Screaming Frog SEO Spider 用户指南、常见问题解答 和 教程,以获取更多建议和技巧。

如果您有任何其他疑问、反馈或改进我们 SEO Spider 中的 URL 检查 API 或 Data Studio 集成的建议,请通过 support 与我们的团队联系。